Una Revisión Sistemática del Uso de Redes Neuronales en el Ocultamiento de Datos

En las últimas décadas, el ocultamiento de información en objetos digitales, especialmente imágenes, ha transitado desde técnicas heurísticas hacia métodos sofisticados anclados en el aprendizaje profundo. La reciente revisión sistemática Neural networks-based data hiding in digital images: Overview realizada por Dzhanashia y Evsutin (2024) constituye un esfuerzo pionero en sistematizar el uso de redes neuronales para steganografía y watermarking, aportando una visión crítica del estado del arte.

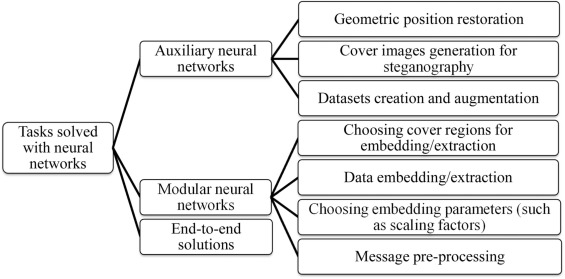

El trabajo destaca que, a pesar del surgimiento explosivo de técnicas que integran redes neuronales en los últimos cinco años, hasta ahora no existía una taxonomía clara que distinguiera entre arquitecturas modulares, auxiliares y completamente integradas (end-to-end). Este vacío se torna más evidente al considerar las aplicaciones emergentes que exigen no solo inserción imperceptible, sino también robustez frente a transformaciones físicas como compresión, recorte, escaneo o captura desde pantalla.

Entre los hallazgos más relevantes, se identifican avances significativos en tres frentes:

Imperceptibilidad

El uso de arquitecturas tipo U-Net, combinadas con funciones de pérdida perceptual (e.g., SSIM, LPIPS), ha mejorado notablemente la calidad visual de los contenedores con datos embebidos. El estudio también sugiere la inclusión de máscaras de textura para ajustar dinámicamente el nivel de inserción.

Robustez

Métodos como DoBMark, StegaStamp o HiDDeN han alcanzado una resiliencia destacable ante ataques intencionales y transformaciones ambientales. En particular, la introducción de bloques de emulación de ataques durante el entrenamiento ha resultado esencial para lograr generalización robusta.

Capacidad y Reversibilidad

Si bien existe una tensión inherente entre capacidad, robustez e imperceptibilidad, ciertos modelos (e.g., DeepMIH) han logrado integrar múltiples mensajes o imágenes sin degradar la calidad perceptual, aunque con desafíos aún presentes en reversibilidad completa y complejidad computacional.

Otro aspecto abordado con acierto es la seguridad frente a técnicas modernas de esteganálisis. Aunque se han propuesto mecanismos adversariales y discriminadores binarios, el número de métodos efectivamente resistentes ante SRNet u otros clasificadores entrenados sigue siendo limitado.

Figura 2. El propósito de las redes neuronales en la ocultación de datos.

En términos metodológicos, la revisión destaca la carencia de marcos replicables. Se sugiere la publicación abierta de arquitecturas entrenadas, datasets con distorsiones reales, y definiciones estandarizadas para métricas de evaluación.

El artículo constituye muestra que esta área del conocimiento es nueva y ha experimentado un importante crecimiento el último tiempo y por su puesto, está lejos de ser un campo resuelto, la investigación señala múltiples avenidas para exploración futura, desde optimización de eficiencia energética hasta simulación de entornos físicos hostiles (screen-to-camera, print-to-camera), evaluaciones estandarizadas con métricas perceptuales (LPIPS, SSIM) y benchmarks públicos, exploración del dominio frecuencial más allá de DWT (p.ej., SVD, Contourlet, Curvelet) y reducción de complejidad.

En resumen, el paper es una delicia para investigadores interesados en ciberseguridad, visión computacional, además orienta muy bien las nuevas contribuciones de alto impacto hacia donde avanzar.

¡Ah!, se me olvidaba, algunas notas especiales que son las que me interesan.

Conjuntos de datos utilizados

- Generalistas: ImageNet, COCO, Pascal VOC, CIFAR.

- Especializados: BOSSBase, BOWS, ALASKA-v2, UCID, SZUBase, Camera-Display 1M.

- Temáticos: Danbooru2019 (anime), CelebA (rostros humanos), UCID (consulta de imágenes).

Resultados destacados

- Imperceptibilidad óptima: arquitecturas con skip connections tipo U-Net + regularización de textura (PSNR hasta 62 dB).

- Robustez sobresaliente: modelos como DoBMark, StegaStamp y Light Field Messaging, capaces de resistir distorsiones del tipo impresora-a-cámara.

- Alta capacidad: métodos como DUIANet y DeepMIH superan los 0.9 bpp permitiendo inserciones complejas.

- Seguridad: solo un subconjunto resiste herramientas modernas de esteganálisis (e.g., SRNet, XuNet, EfficientNetB4).

Herramientas desarrolladas

- Frameworks con código abierto: ROMark, ReDMark, HiDDeN.

- Redes con capas invariantes y bloques de ataque diferenciados.

- Módulos de atención y de realce para mejorar la extracción en condiciones adversas.